Your web browser is out of date. Update your browser for more security, speed and the best experience on this site.

Boeken omzetten in bruikbare kennis met AI: de cruciale rol van chunking

Hoe maak je volledige boeken bruikbaar voor AI zonder dat betekenis verloren gaat of het systeem overbelast raakt? Dit was de uitdaging waar wij voor stonden bij het bouwen van een AI-chatbot die vragen kon beantwoorden op basis van grote documentcollecties, waaronder complete boeken. De oplossing maakte gebruik van Retrieval-Augmented Generation (RAG), maar de echte sleutel tot succes was minder spectaculair dan het nieuwste taalmodel: het ging om hoe we de tekst hebben gechunked. Willem Dendauw, .NET consultant bij Axxes, licht het verder toe in de nieuwste Insight!

De uitdaging: van boeken naar gesprekken

Bij lange documenten zoals boeken, onderzoeksrapporten of juridische archieven werkt het niet om simpelweg de volledige tekst aan een AI-model te voeren. Modellen hebben strikte contextlimieten en raken informatie kwijt die diep in lange teksten verstopt zit. Tegelijk verwachten gebruikers precieze, conversatiestijl antwoorden ongeacht of de bron nu een paar honderd pagina’s of duizenden beslaat.

RAG overbrugt dat gat door AI-antwoorden te verrijken met kennis die wordt opgehaald uit een speciale documentindex, namelijk een vector database. Maar om dat mogelijk te maken, moeten de documenten eerst worden opgedeeld in chunks: beheersbare segmenten die efficiënt kunnen worden geëmbed, opgeslagen, en teruggehaald.

Het probleem? Hoe je de tekst chunked, bepaalt rechtstreeks de kwaliteit van de chatbot-antwoorden.

Onze aanpak: Experimenteren met chunking-strategieën

In ons project hebben we meerdere chunking-strategieën getest om de beste balans te vinden tussen nauwkeurigheid, behoud van context, en prestatievermogen:

1. Chunking op vaste grootte

We verdeelden de tekst eerst in blokken van gelijke lengte (bijvoorbeeld elke paar honderd woorden).

- Voordelen: Simpel, snel en voorspelbaar.

- Nadelen: Geen oog voor betekenis. Chunks sneden vaak door zinnen of ideeën heen, wat leidde tot gefragmenteerde antwoorden zonder voldoende context.

2. Semantische chunking

Daarna splitsten we teksten op natuurlijke grenzen zoals zinnen, paragrafen of secties.

- Voordelen: Behoud van betekenis binnen elke chunk, wat resulteerde in veel relevantere en coherente zoekresultaten.

- Nadelen: Minder voorspelbare grootte. Sommige chunks waren heel kort en andere te lang, wat de consistentie van de resultaten aantastte.

3. Hybride chunking met overlap

Tot slot testten we een hybride methode: grotendeels vaste blokken, maar met respect voor semantische grenzen, én met lichte overlap tussen chunks.

- Voordelen: Het beste van twee werelden: efficiënte indexering, zonder verlies van betekenis aan de randen van chunks. Overlaps bleken vooral nuttig om continuïteit te waarborgen wanneer antwoorden afhankelijk waren van informatie die over twee chunks verspreid zat.

- Nadelen: Meer resources nodig, omdat overlap de totale hoeveelheid te verwerken tekst vergroot.

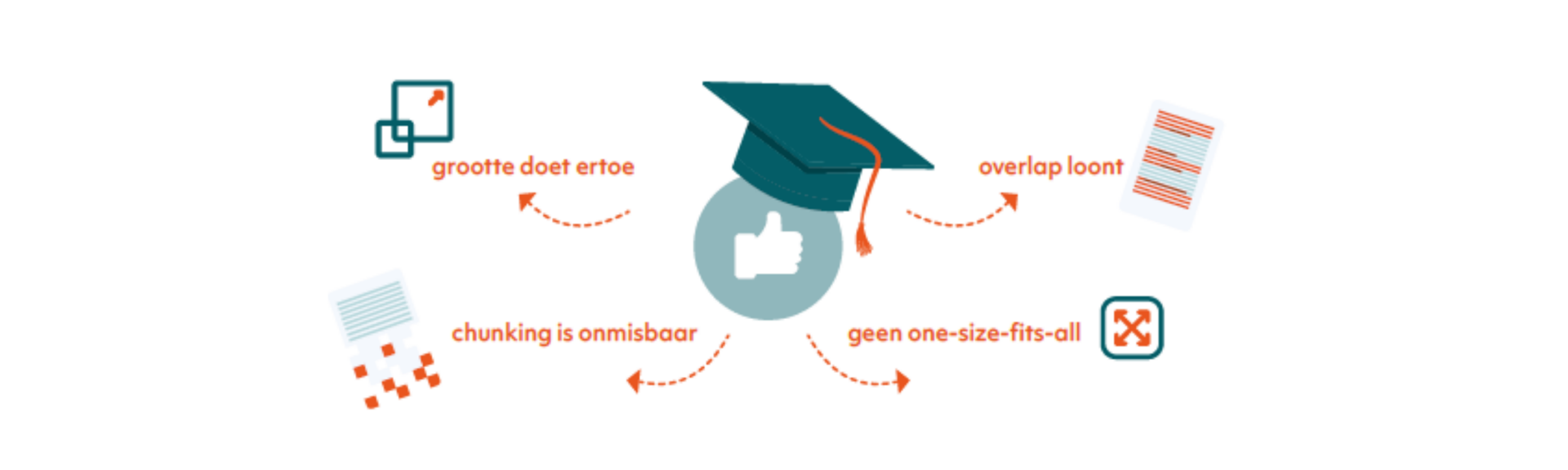

Wat we hebben geleerd

Uit praktijkervaring kwamen enkele duidelijke lessen naar voren:

- Chunking is onmisbaar. Zonder chunking is retrieval óf te grofmazig (hele boeken als één blok) óf te gefragmenteerd (minuscule snippets, zoals zinnen, zonder context).

- Grootte doet ertoe. Te kleine chunks verwarden het systeem met losse details; te grote chunks lieten belangrijke informatie “in het midden verdwijnen.”

- Overlap loont. Zelfs een bescheiden overlap verbeterde het vermogen van de chatbot om complexe vragen over meerdere paragrafen heen te beantwoorden.

- Geen one-size-fits-all. Verschillende contenttypes (verhalende boeken, gestructureerde rapporten, naslagwerken) vragen om verschillende chunking-strategieën.

De impact

Door onze chunking-strategie te verfijnen, konden we de chatbot:

- Directe, goed onderbouwde antwoorden laten geven op gebruikersvragen.

- Vragen over meerdere boeken tegelijk laten afhandelen zonder context te verliezen.

- Probleemloos laten opschalen naarmate meer documenten aan de collectie werden toegevoegd.

Voor ons project betekende dit dat enorme hoeveelheden kennis voorheen opgesloten in statische PDF’s of lastig doorzoekbare archieven direct toegankelijk werden via natuurlijke conversatie.

Waarom je chunking strategie van belang is

In RAG-systemen is chunking veel meer dan een voorbereidende stap. Het is een onderdeel van de strategie die bepaalt hoe kennis wordt opgeslagen, teruggevonden en uiteindelijk begrepen door AI. De juiste chunking-strategie bepaalt of een chatbot intelligent en behulpzaam aanvoelt, of juist gefragmenteerd en onbetrouwbaar.

Onze ervaring laat zien dat, ook al blijven de modellen zich ontwikkelen, het juist deze doordachte engineeringkeuzes zijn, die bepalen of AI in de praktijk écht waarde oplevert.

Wil je ook aan de slag met AI in jouw organisatie?

Van idee tot impact met AI, zonder concessies aan security. Axxes staat klaar om mee te bouwen!